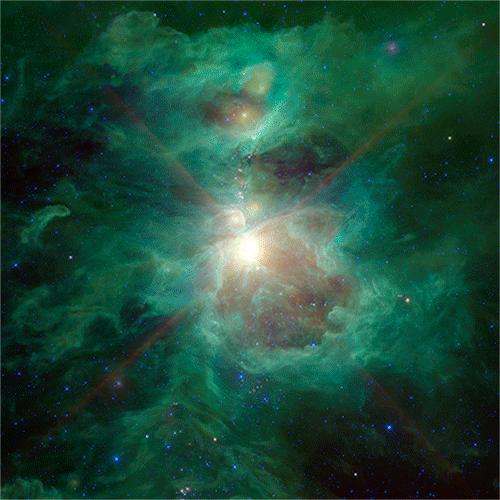

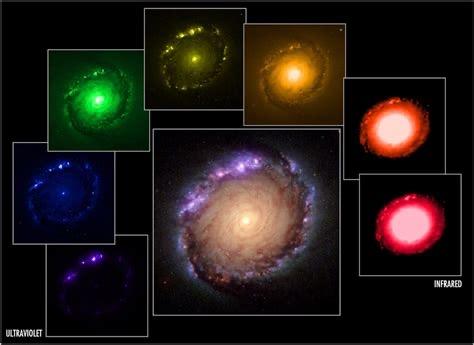

很多人看到的太空照片是酱婶儿的

实际上哈勃太空望远镜拍出来的是酱紫的

应大家要求,再来一组:

是NASA在显摆自己的ps,哦不,photoshop的技能么?颜色又是怎么来的呢?

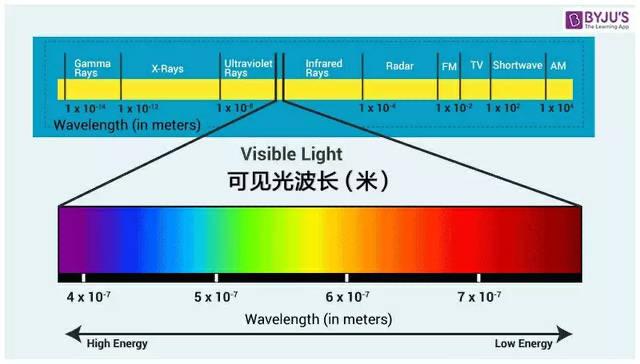

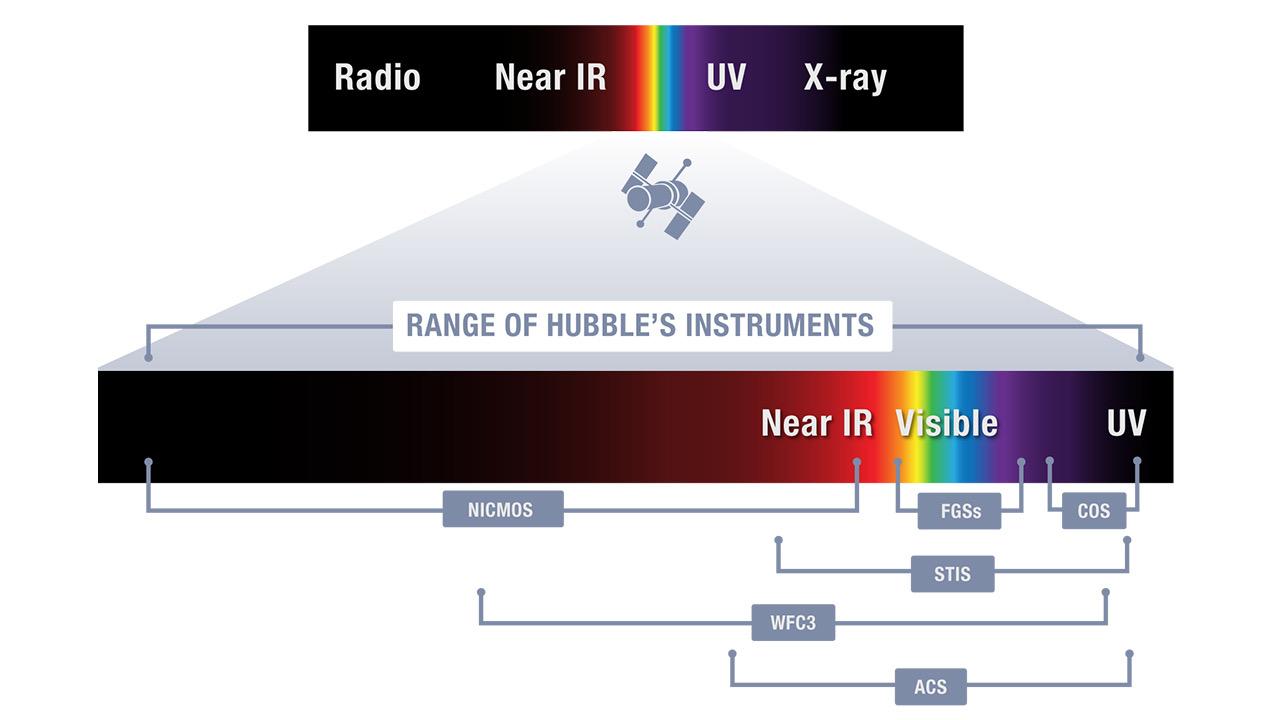

首先,我们人类的眼睛只能看到电磁波谱中很有限的一部分,从红到紫,称为“可见光谱”。

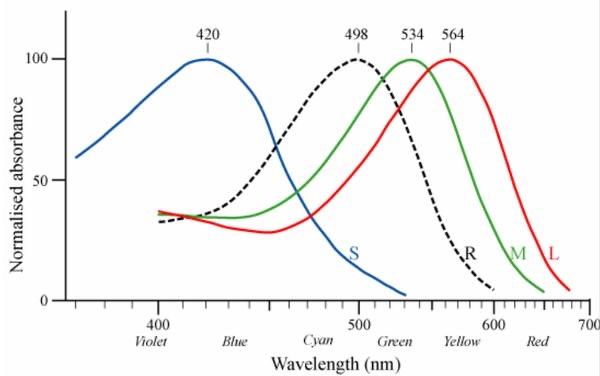

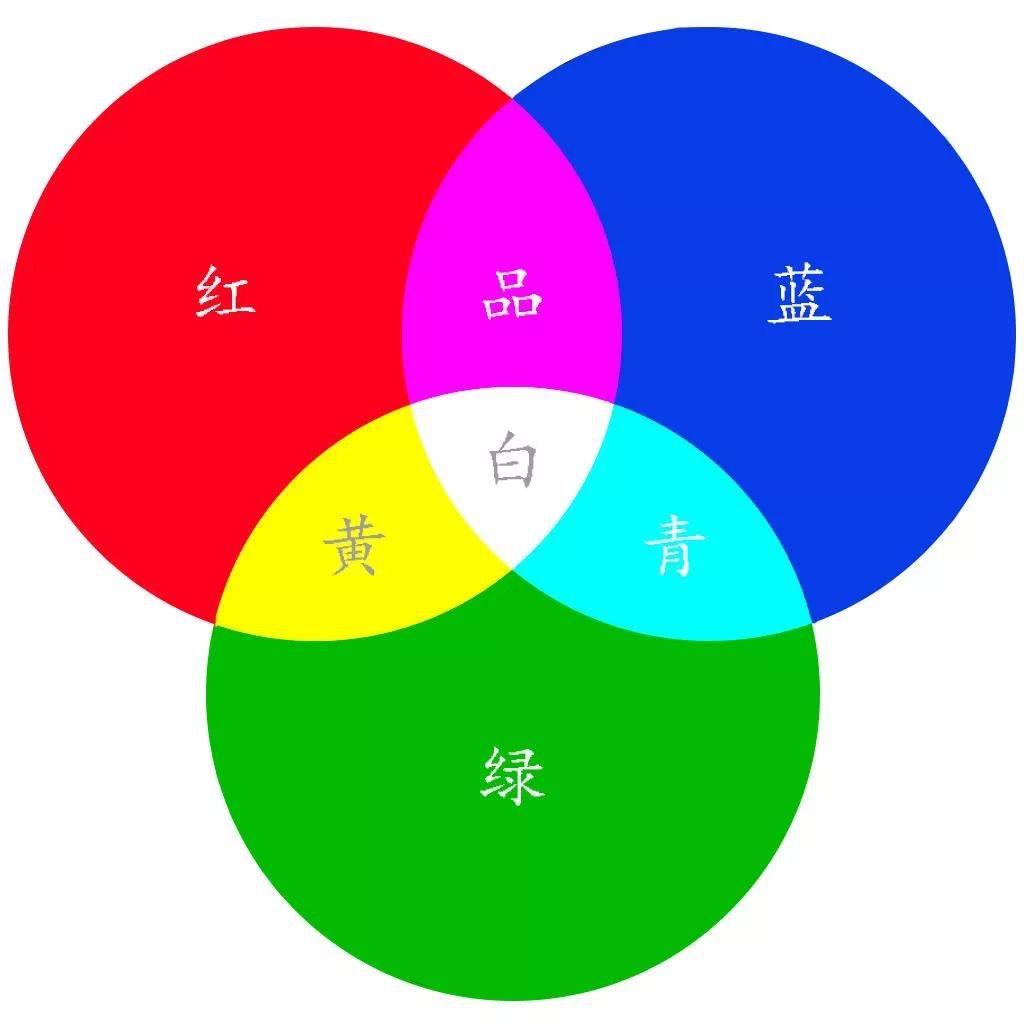

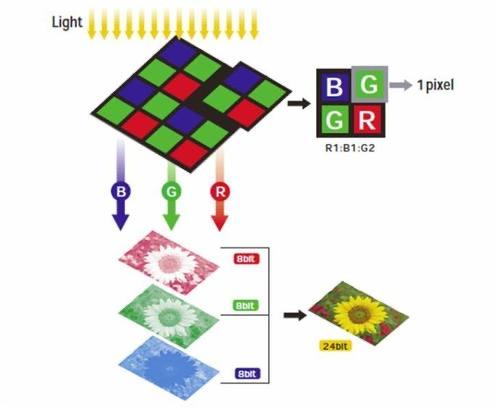

目前主流学说认为正常的人眼存在3种含有不同感光色素的视锥细胞,分别对短、中、长波敏感,相对应就是大概蓝绿红3种颜色,三个颜色通过不同的搭讪组合,构成了人眼所见的色彩。

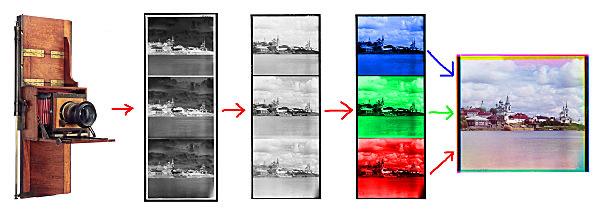

这就是黑白照片的着色原则。

接下来举个例子

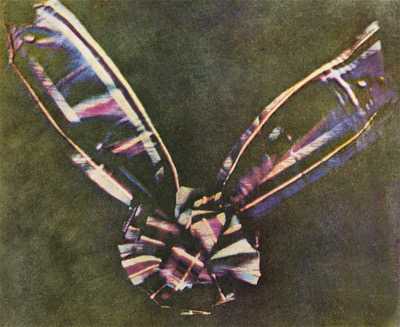

上图是人类第一张彩色照片《苏格兰花格呢缎带》(Tartan Ribbon)by 麦克斯韦尔(名字有没有很耳熟?)。

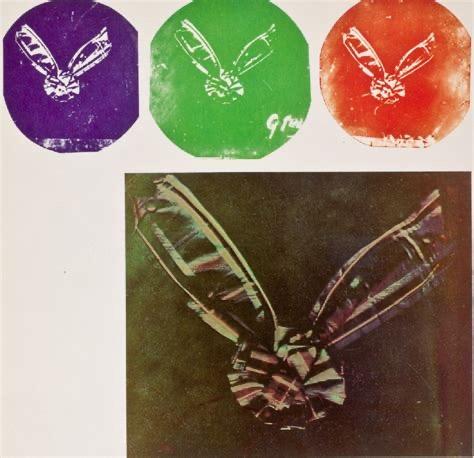

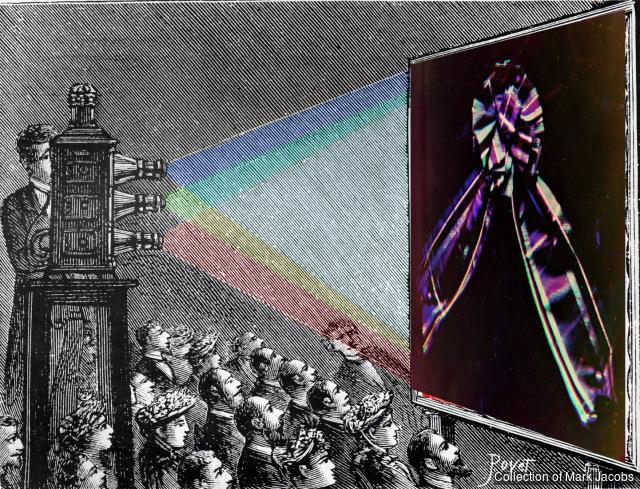

1861年,他的摄影师托马斯·萨顿对着这条缎带拍摄了三幅同样的照片。然后用三部放映机同时将映像透射到银幕上,每部放映机镜头前都拧上不同颜色的滤镜。

麦克斯韦尔提出用这三种色可以混合出世间的任意一种颜色,他的这个论断在这次放映试验上得到了验证——他得到了一张彩色的图片。

但是有时候在拼的时候人手会抖,就变成了故障艺术的源泉。

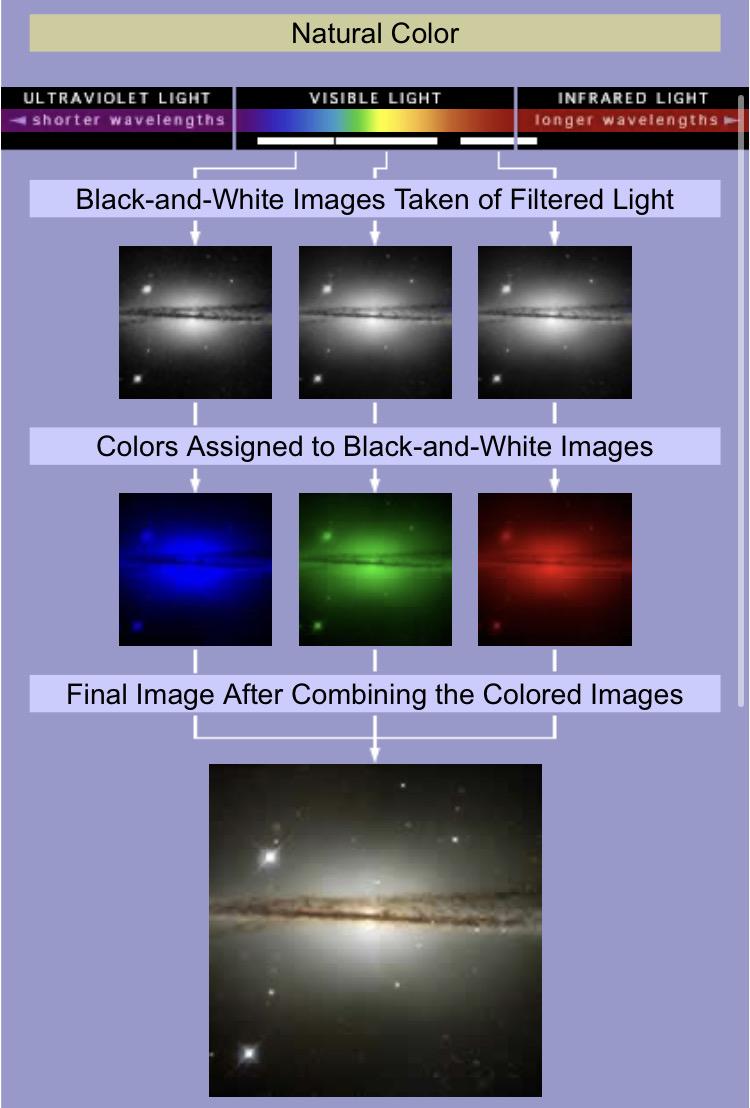

哈勃望远镜也是差不多的道理,即窄带摄影法。它拍照时使用滤镜仅曝光某个窄波段甚至是H O S几种元素的宇宙辐射,所以传回的每张照片原始件都是黑白的,然后对几个通道分别添加理论色彩得到最后的彩色照片。

比如下面这张照片,将光分离成长、中、短波,根据它们在可见光谱中的位置,给3张照片上色,合成出来就是真实的颜色了。

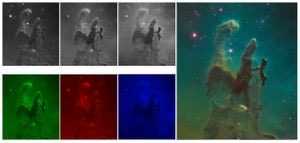

最著名的例子就是这张“创世之柱”。1995年,美国太空总署用哈勃太空望远镜在对准6500 光年以外的天鹰星云,拍下了被命名为“创世之柱(Pillars of Creation)”的照片。创世之柱所在的天鹰星云也被称之为“M16星云”。

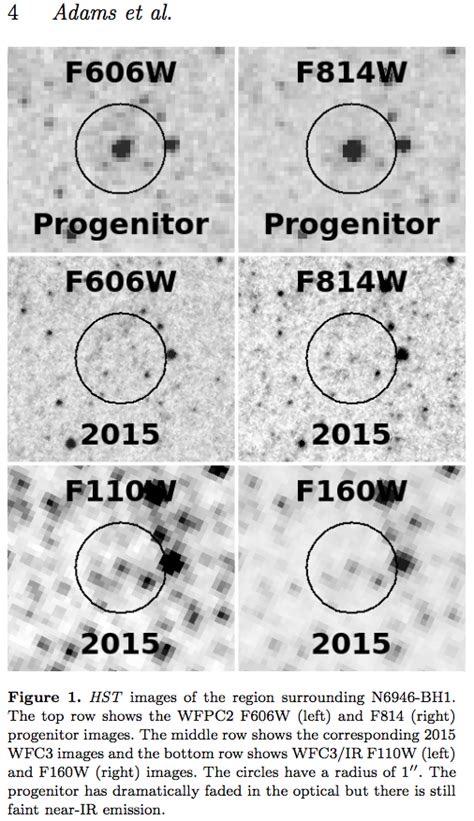

20年后,哈勃太空望远镜再次拍摄创世之柱,这回用的是在 2009年所安装的新款照相机第三代广域照相机(Wide Field Camera 3)。解析度提升后,捕捉到气体星云的多种颜色、深色宇宙尘微弱的卷鬚,和赭色的象鼻状气体柱。

20年间,颜色变好看了?然鹅,这不是它的真实色彩图像。

下图左边上方的三张为原始图,左下三张为人工着色图,右侧为人工合成图。

氧元素的窄波大图如下:

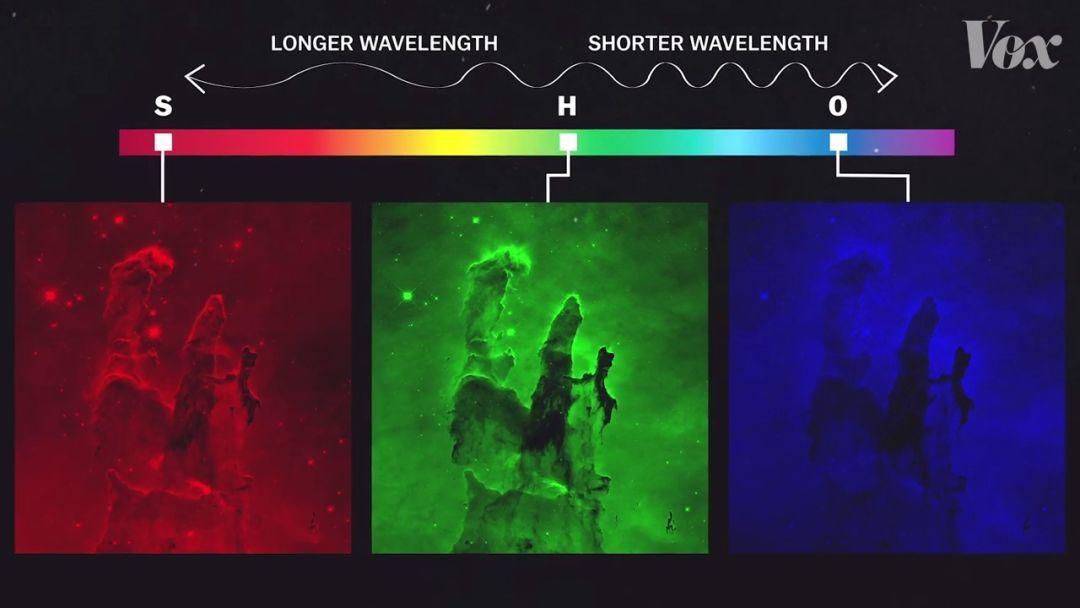

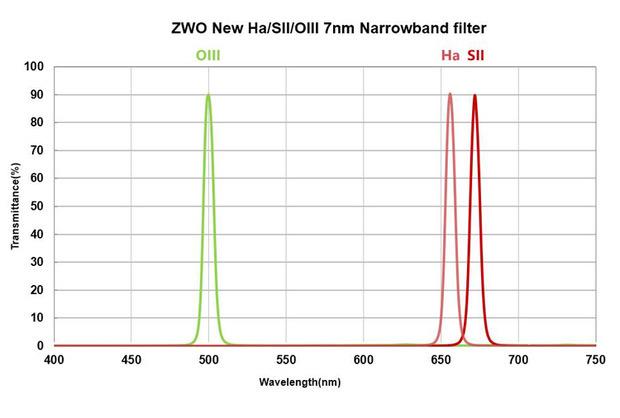

那绿红蓝三个颜色是怎么指定的呢?

H氢和S硫在红光可见,O氧在蓝光可见。

把它们着色再合成,就会得到下面这张图象。

对视觉分析来说不是很有hao用kan,因此科学家们就根据它们的顺序重新分配颜色,氧有最高频率,被指定为蓝色,氢低于氧但高于硫,便以绿色代表,硫以红色代表。

给它们重新上色之后,得到的图像就是像下面这样的了。

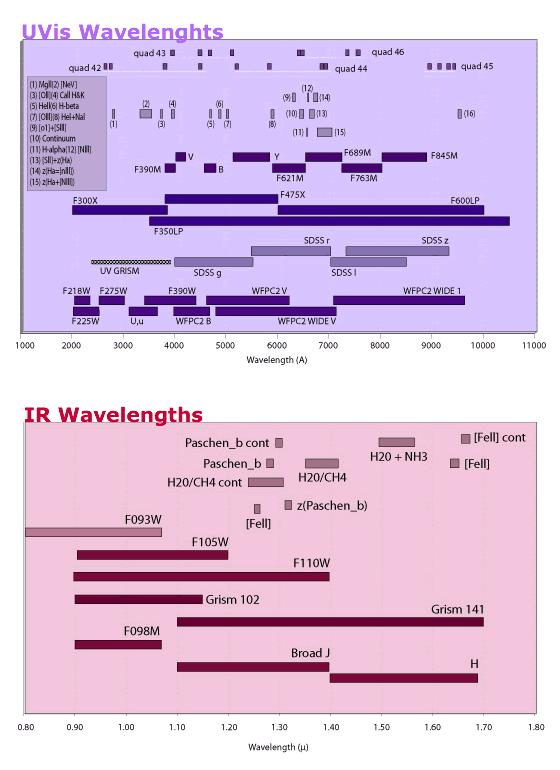

哈勃望远镜通过第四代WFC3的超宽波长范围、宽视场和高灵敏度的结合来提高其探查和发现能力。 WFC3的主要优势是它的全色波长探测范围。通过将两个光学/紫外线CCD与近红外HgCdTe阵列相结合,WFC3能够在200至1700 nm的整个波长范围内进行直接的高分辨率成像。

比如创世之柱的红外图像看起来就非常不同。尘埃和气体云层挡住了可见光,但是较长波长的可以通过,就显示出了星团。

根据不同频率分配不同颜色,就能创造出不同用途的图像。

天文学家必须选择如何以一种我们可以直接观察的方式来展现这些信息。有时他们会采用三基色自然对应长中短可见波的这种表现形式,有时他们会选择用三个颜色来对应那些看不见的元素,这有助于他们看到物体的不可见特征,例如只能在红外或紫外线下捕获的特征。有时,它们以一种超现实主义的颜色增强显示图像,可带来许多隐藏的微妙细节。

为了获取更丰富的星空信息,并让人眼更直观的了解和分析各种宇宙天体,哈勃望远镜会使用不同滤镜多次拍摄同一场景的黑白照片,然后后期转化成若干幅图像。每幅都代表着不同原子所发出的辐射。

为了体现出这些照片的不同,人为地给不同元素照片指定三基色标准,将宇宙更不真实的但更美妙直观地展现出来。这样也可以显现出星云不同区域物理性质的不同。因为色彩不仅让我们感受到宇宙的绮丽,还揭示出宇宙中我们看不见的部分。

所以天文爱好者不仅仅要学习好物理,PS也是很重要的。

问题一:有知友问,卡萨林式哈勃望远镜的CCD成像方式和我们手上的消费级彩色照相机的有什么不同?为什么用滤镜这么古老的方法?

答:CCD工作原理差不多,不就是感光成像嘛。但也有一点不同,那就是如何探测颜色。

CCD无论是在手机上还是哈勃上,都是只计算处理光的强弱,无法直接探测到色彩。民用相机的CCD的原理如上图,通过在每个象素的感应器前方安置一个色彩滤镜来完成这个任务。除了大法外,通常是一半取(人眼额外敏感的)绿色,四分之一取红色,四分之一取蓝色。然后通过各种算法臆测重建图像色彩。这对拍私房拍风景是相当完美了,只要不放大是不会看到偶尔的色彩噪点颗粒的。

但对于天文学家来说,每一个象素都具有潜在的科学价值,一个噪点有时就能毁了整个观测。所以哈勃受用了将所需的单色滤镜置于所有像素感应器前。这样以来,相对于民用数码摄影,精确度有了大幅度提升。数码相机只能捕获到红绿蓝,而哈勃却可以用众多滤镜在不同波段(可见光、红外、紫外...)拍摄。

问题二:色彩有什么用?就为了好看?

答:色彩不仅告诉我们关于温度高低的信息,还可以告诉我们光是在何种介质中穿行,甚至告诉我们观测对象由什么元素或成分组成,特定光会和特定气体一一对应。

但由于全球科学家都在抢着用哈勃,所以用四个以上的滤镜拍摄同一观测目标是很奢侈的也很不常见的行为。

当然,可见光照片的色彩美丽但照片信息确实有限,摄谱仪则能在连续谱线上探查足够多的细节。几乎所有哈勃关于系外行星系统的发现都来自于摄谱仪。

更新问题三:那哈勃的彩照都是与我们实际看到的不一样的么?那宇宙用肉眼看到底是什么样子?

答:哈勃望远镜也通过宽带滤光片曝光,可以得到最接近“真彩色”图像的HST近似值,从而将可见光谱很好地切成三个相等的部分。这些切片与我们的眼睛的红色,绿色和蓝色反应严格匹配。拍出的照片比柯达胶卷更接近肉眼感觉。宽带滤光片包含多条可见光谱,但同时也减少了星云中固有的非可见光颜色,从而降低了对比度。所以当你看到一张照片的颜色相对不那么饱和且柔和的时候,有可能和肉眼接近。

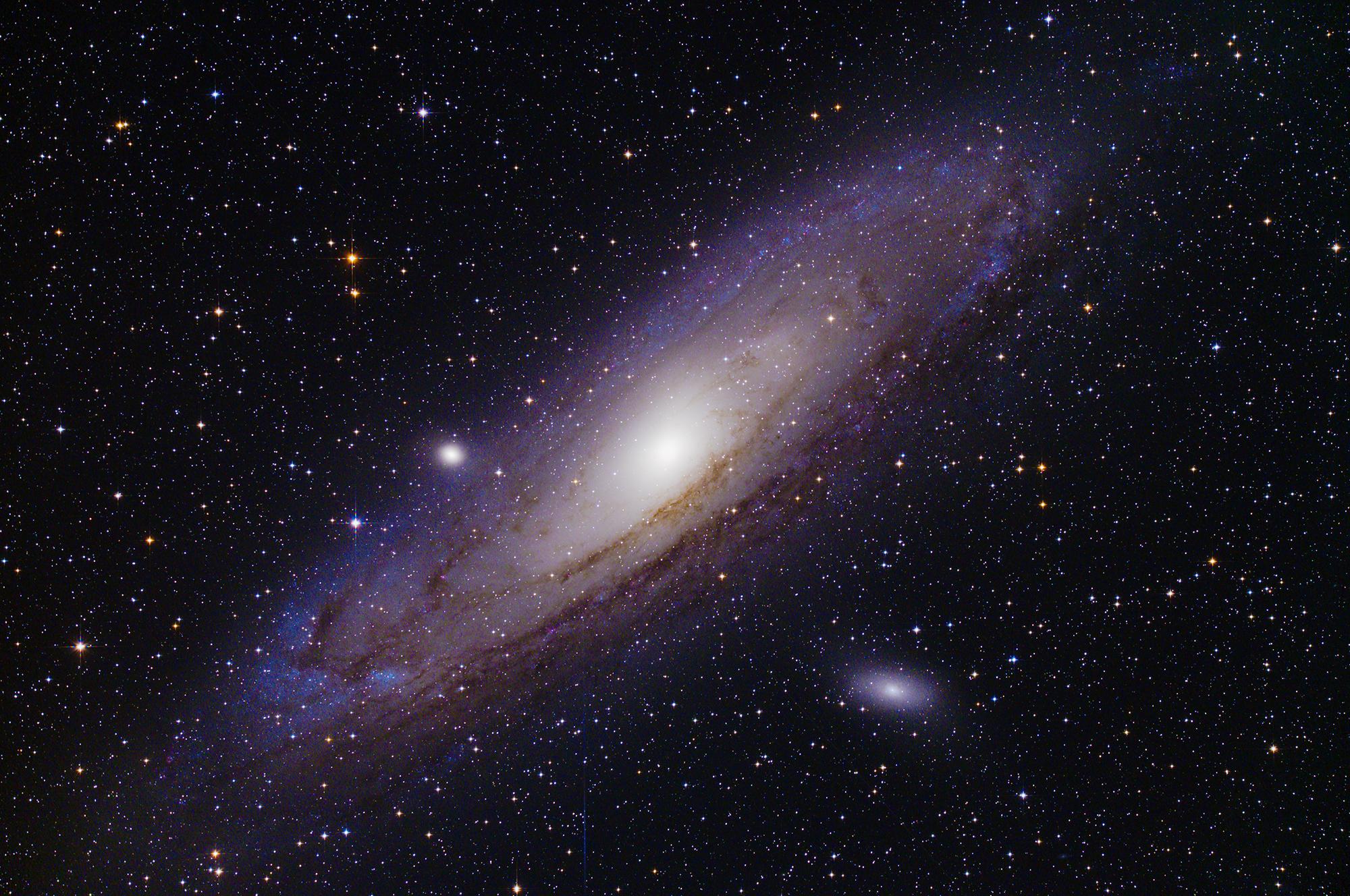

实际上,黑暗的宇宙更接近下图的样子,但要比它暗很多很多。就算你穿越时空来到那些壮美的旋涡星系和色彩斑斓的星云前,你的眼睛依然难以捕捉到这些过暗的倩影。(从地球上看,仙女座有6个满月那么大,但你看不到,因为太暗)

当然,如果离特定天体比较近,可以看到它的颜色,是的,它们是有颜色的。

更新问题四:我们在地球用相机加望远镜也能拍出来这样的颜色么?

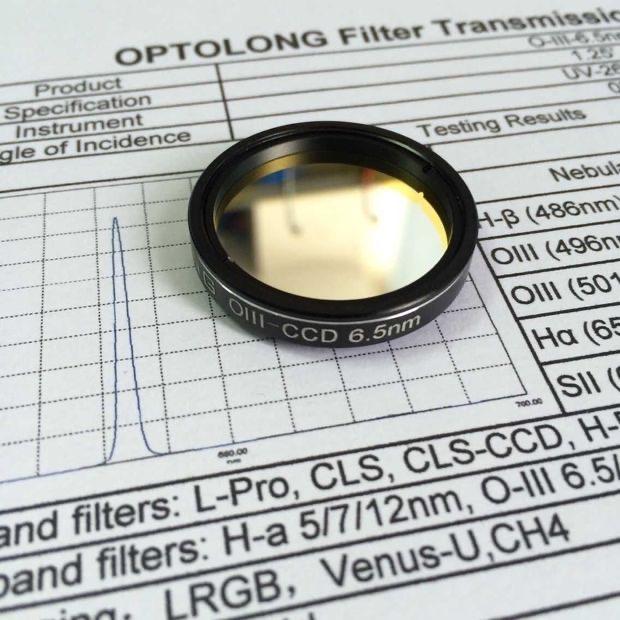

答:可以。首先,要去买三个窄带滤镜 Ha,OIII,SII,长得就类似下面这样(拒绝推荐具体品牌)

滤镜分别代表氢α,氧III和硫II原子被激发而发出的光,大部分星云的主要组成元素就是氢原子,所以Ha通道会展现出很多星云的细节。OIII和SII也是比较主要的星云发光源。

如果想接近肉眼观察的颜色。那么Ha波段做红色通道(通常拍出来就是红的),OIII波段做绿色通道,SII作蓝色通道。

但如果想拍出上面那种梦幻般的彩色(被称为哈勃色),可以采用把SII作为红色,Ha作为绿色,OIII作为蓝色。相较上一种方法合成出的基本都是红红一片的照片,这种方法合成出的星云颜色更炫酷,所以被更广泛使用,但并不贴近星云实际的颜色。

想要贴近实际颜色,可以拍宽带的RGB通道,然后再将Ha(Ha可以去光污染,提高信噪比从而提升照片质量,当然有时间有钱可以上全三种)窄带通道作为L(亮度)通道,可得一幅最大还原星云原貌的照片。

如果不拍星云只拍星系的话,那只需用到LRGB通道就行,因为星系的光主要是恒星产生的,和星云不同。

更新问题五:哈勃望远镜有多少片滤镜?

光是勃望远镜的第三代广域照相机(WFC3),就有N多个滤镜。具体可见下图。UV段47个加一个棱栅,IR段14个加二个棱栅。

欢迎提出好问题。

星云中的动物

好了好了,更新了M78星云了还不行么,不要再私信我问我奥特曼的问题了。。。。我真不知道。。。。。

本文参考

Extreme star cluster bursts into life in new Hubble imageNASACHINA.cnExtreme star cluster bursts into life in new Hubble imageNASACHINA.cn

https://www.vox.com[The universe through the eyes of Hubble]-Oli Usher and Lars Lindberg Christensen 2014

https://hubblesite.org/resource-gallery/images注:NASA的图片不受版权限制,美国联邦版权法拒绝对联邦政府的作品进行版权保护。————NASA Copyright Notification

我有,以下图片都是自己拍的,全部是相机RAW文件,未经任何PS和人工处理,由于原始存档一直都有留档,所以拿出来可以给大家分享一下。

如果题主想问用肉眼直接观测是什么效果?那大概就是下图这样……还是第一张图的M42

这是我的深空摄影处女作,当时只有一款玩具级的望远镜(星特朗80EQ)这个效果和用双筒或小口径望远镜在郊区看M42效果差不多,当然在弱光条件下人眼是看不见颜色的,所以看起来应该是黑白的。

“没有人工处理过”和“真实”非但不是一回事情,很多情况下甚至是互斥的。

让我们假设一个遥远的天体,它发出各种颜色的光。这些光来到了地球。

-这些光在进入望远镜之前,会被翻滚的大气折射、散射,锐利的星象会变得模糊、偏色;

-你上空的大气会散射附近城市的灯光,让图像上出现弥漫的光晕。甚至高层的大气本身就会发光;

-望远镜不可避免地存在像差,折射镜有色差,反射镜有其他像差;

-相机的传感器因为电子的热运动,会随机出现一些噪声;来自宇宙射线的粒子,也会随机撞击传感器,留下一些并不存在的亮点。

当拿到这样一副“没有人工处理过”的照片,你可以称它是“真实”的吗?当各种各样的处理手段作用在原图上,展现出图像中隐藏的细节,去除干扰,得到的照片是不是更贴近“真实”呢?

更何况人的眼睛有天然的限制。天体能够发出各种波长、各种颜色的光,但是人眼只能感受到三种。两束光在人眼看来可能是同一种颜色,但是它们的波长成分可能大相径庭。而更多的时候,人眼根本就不能感受到这些光。如果所谓“真实”就是一片黑的话,那就毫无意义了。最好的情况,人眼也只能看到一部分“真实”。

那么怎么看到另一部分人眼看不到的“真实”呢?就是要“人工处理”了。

入天文摄影坑一年,拍了不少的深空天体照片,比如前两个月刚拍的仙女座星系(M31):

猎户座大星云(M42):

心脏星云(IC 1805):

马头星云(IC 434):

当然,这些深空天体照片都是经过后期处理的。深空天体十分暗淡,为了捕捉到它们,需要进行长时间的曝光。一般都是单张曝光几分钟,然后多张叠加成一张,这样可以提高信噪比,获得理想的照片。

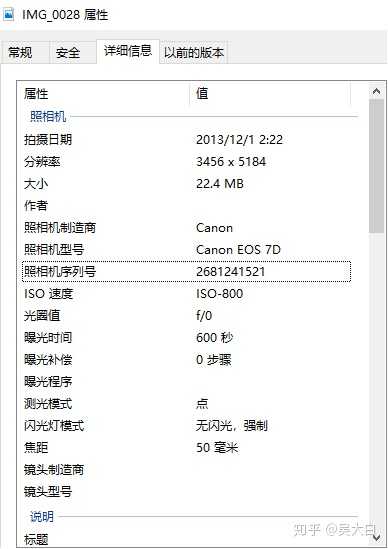

本人使用单反+口径为150毫米的牛顿反射式天文望远镜+EQ5级赤道仪+彗差修正镜(MPCC)+导星镜&导星相机。以仙女座星系为例,为了拍摄这个肉眼可见的星系,先用赤道仪goto到仙女座星系,然后赤道仪跟踪,并且配合导星修正,始终让天文望远镜对准仙女座星系,这样拍出的星点才不会出现拉线的现象。单张曝光5分钟,得到如下未处理过的RAW格式照片:

总共拍摄了12张这样的照片,同时还拍摄了各种校准帧。然后,用软件把这些照片叠加到一起,得到了如下的图片:

由于叠加出来的是16位照片,人眼无法适应这种线性图片,所以看起来几乎是黑色的。为此,需要用其他软件对这种线性图片进行拉伸,这就是所谓的DDP过程。做过DDP之后,图片就会适合人眼观看,所以很多细节就能呈现出来。最终处理出来的仙女座星系图片如下所示:

由于对12张曝光5分钟的照片进行叠加,这相当于曝光了1小时。

下面这张是位于1200万光年外的雪茄星系(左,M82)和波德星系(右,M81),6张曝光5分钟的照片叠加,累计曝光时间30分钟:

累计曝光80分钟的三角座星系(M33):

累计曝光20分钟的鹰状星云(M16):

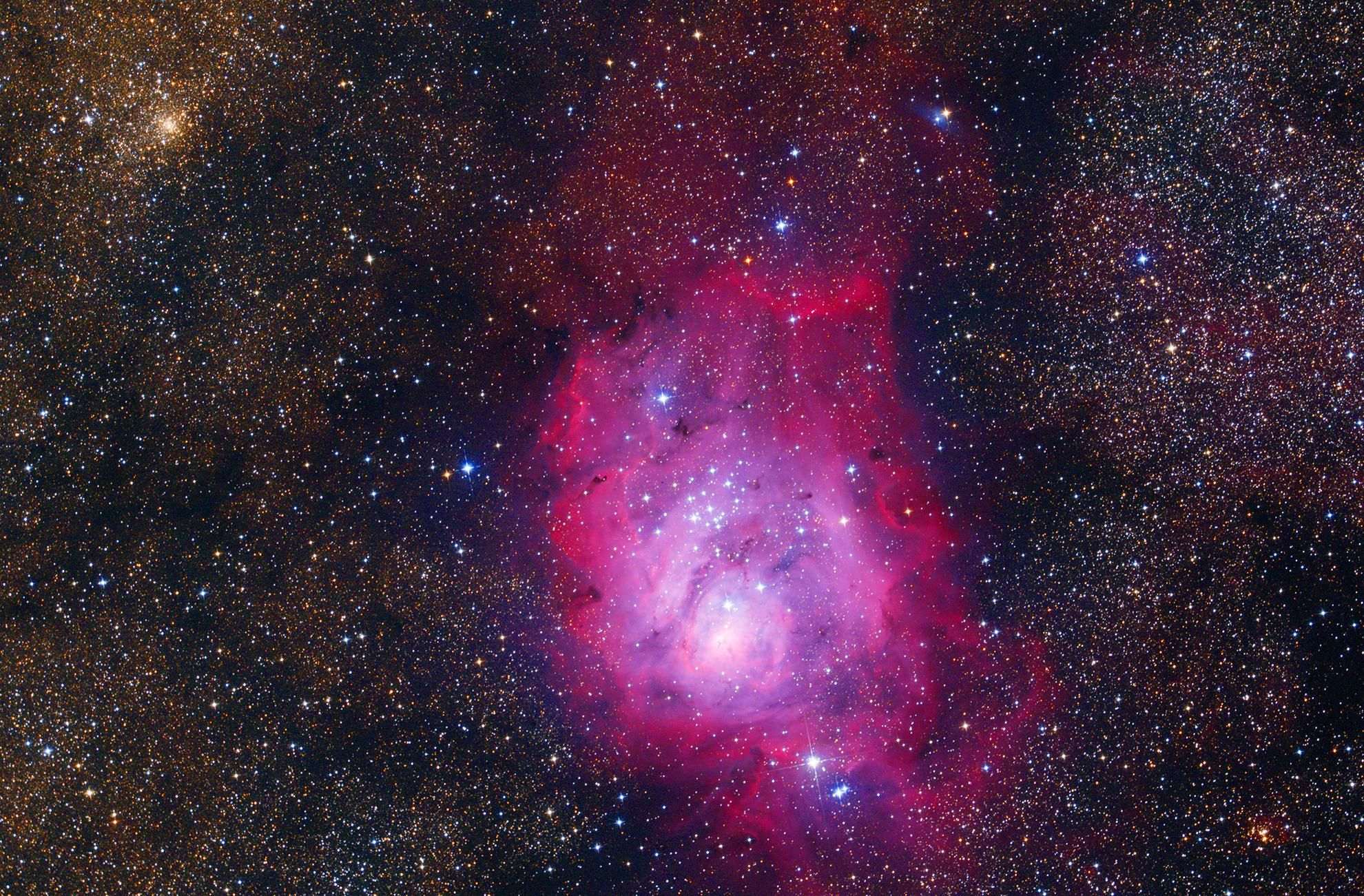

累计曝光20分钟的礁湖星云(M8):

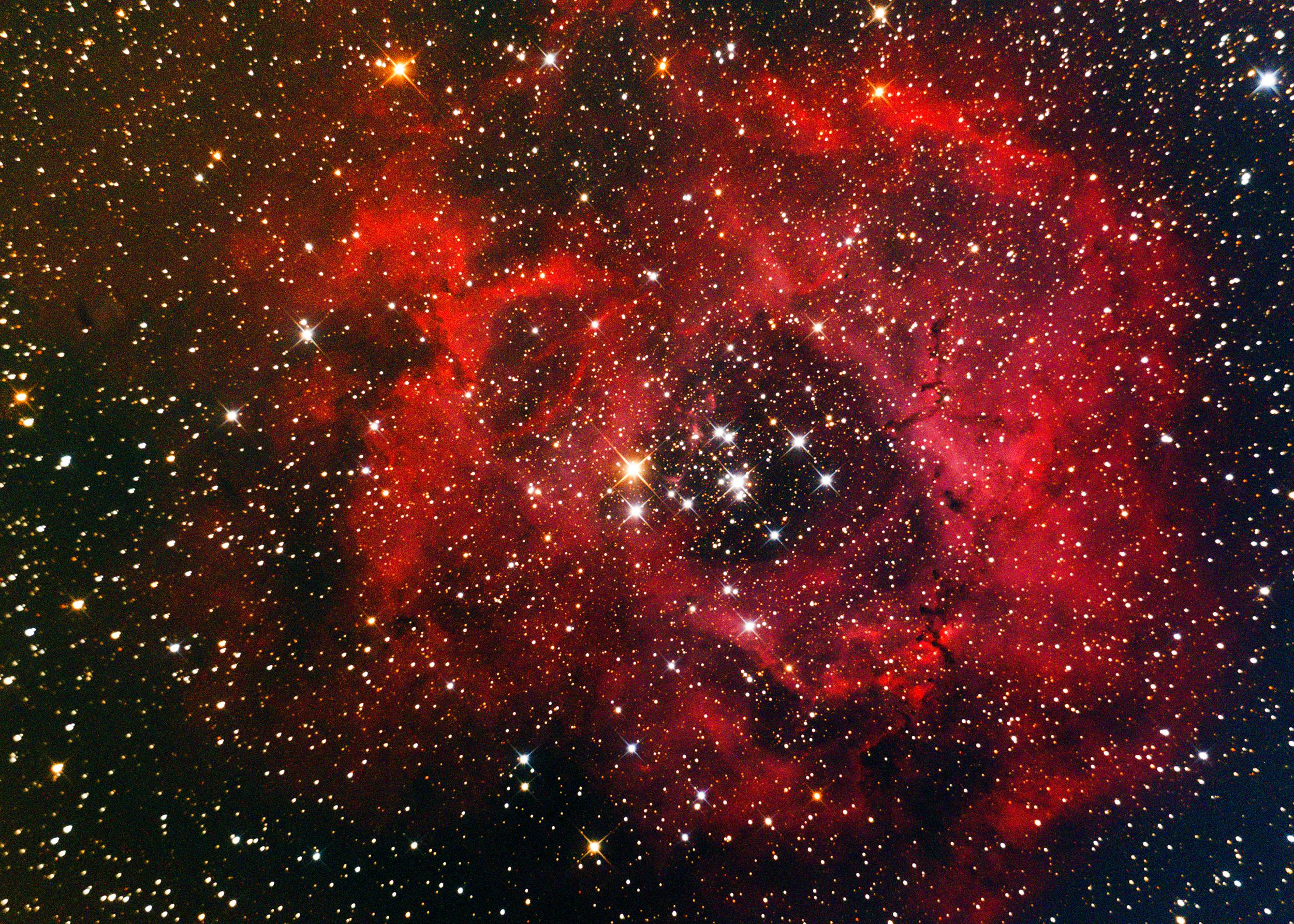

累计曝光55分钟的玫瑰星云(NGC 2237):

累计曝光1小时的蟹状星云(M1):

累计曝光1小时的M78星云:

累计曝光30分钟的昴星团(M45):

累计曝光55分钟的螺旋星云(NGC 7293):

累计曝光10分钟的疏散星团M52和气泡星云(NGC 7635):

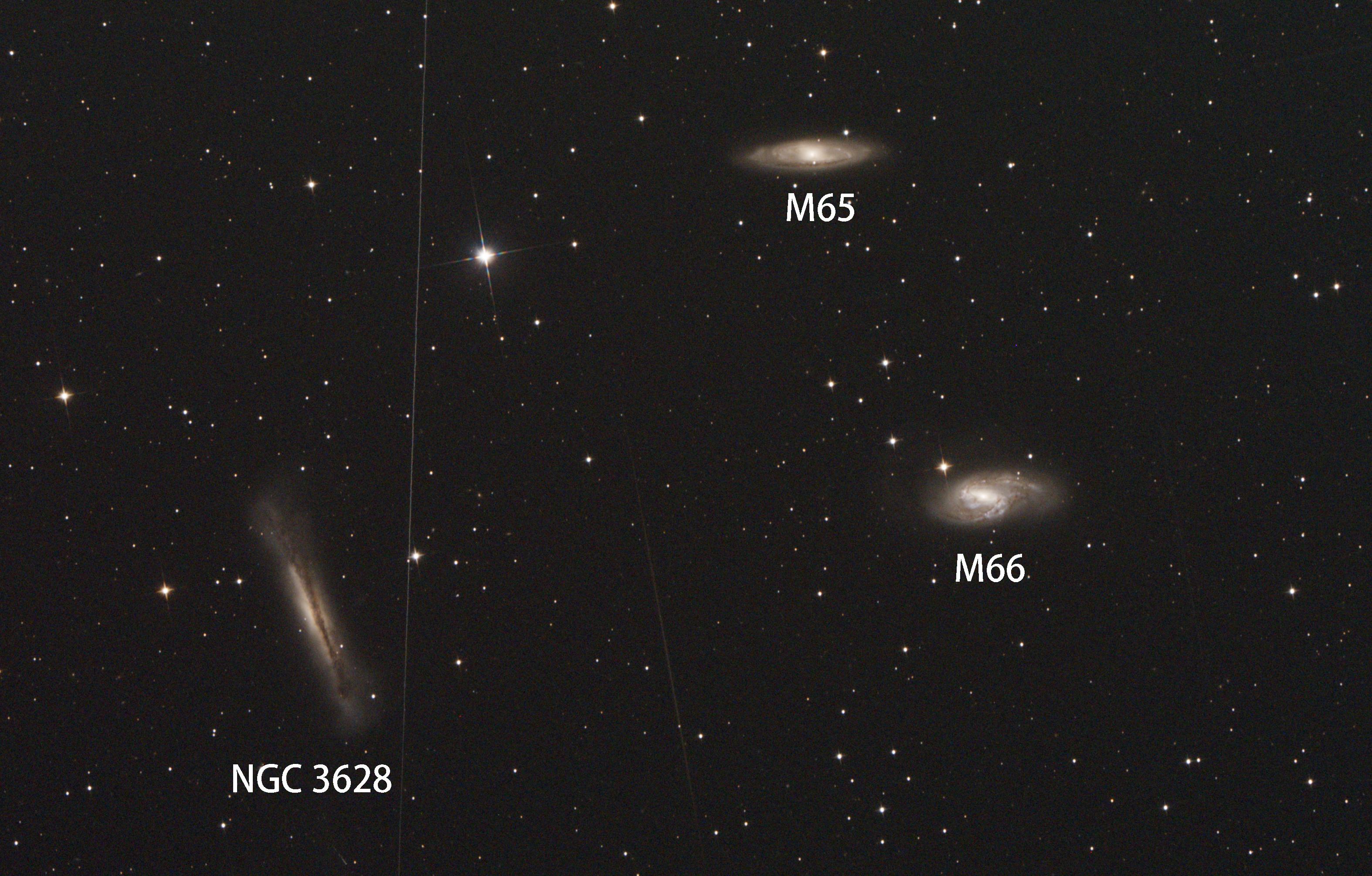

累计曝光70分钟的狮子座三重星系(NGC 3628、M65、M66):

累计曝光80分钟的风车星系(M101):

累计曝光1小时的草帽星系(M104):

累计曝光2小时的涡状星系(M51)及其伴星系M51a:

累计曝光20分钟的圣诞彗星46P/Wirtanen:

今年中秋拍摄的满月:

木卫一凌木:

金星盈亏:

最后设备图:

补一张新拍的昴星团,跟上一张拍摄时间相隔一年,这张累计曝光时间2.75小时:

换了黑白冷冻相机ASI1600MM,LRGB方式出图,再补几张后来拍的深空天体照片:

真实火星表面https://www.zhihu.com/video/1234039212405874688

真实火星表面https://www.zhihu.com/video/1234039212405874688